Este artículo se ha actualizado el 27 de diciembre de 2024.

En este artículo de “Divulgación Jurídica de Illán”, analizo el impacto de la IA en la Justicia en el derecho español y comparado, desde una perspectiva amplia, abarcando no solo el Derecho en sentido estricto, sino también el impacto en el empleo, el trabajo en el día a día de los operadores jurídicos y cuestiones éticas.

Índice

1. El impacto en la Abogacía

1.1 ¿Puede la IA ejercer la abogacía? La historia de DoNotPay

1.2 El impacto de la IA en el trabajo de los abogados

2. El impacto en la Administración de Justicia

2.1 Guía del Poder Judicial de Inglaterra y Gales sobre el uso de la IA por parte de los cargos judiciales

2.2 El uso de la IA en el sistema judicial alemán

2.3 El uso de la IA en el sistema judicial de China

2.4 La primera sentencia del mundo con ayuda de la IA, en Malasia

2.5 El uso de ChatGPT para dictar sentencia en Brasil (presuntamente) y Países Bajos

2.6 Proyectos para aplicar la IA en el sistema judicial español

2.7 El uso de la IA en el sistema judicial de Iberoamérica (Brasil, Argentina, Colombia y México)

3. El Reglamento de Inteligencia Artificial de la Unión Europea

4. El Convenio Marco del Consejo de Europa sobre inteligencia artificial y derechos humanos, democracia y Estado de derecho

5. Cuestiones éticas relacionadas con la IA

6. Bibliografía

1. El impacto en la Abogacía

1.1 ¿Puede la IA ejercer la abogacía? La historia de DoNotPay

Voy a comenzar el artículo con pregunta de si la Inteligencia Artificial puede ejercer la Abogacía y representar directamente en un juicio. La respuesta es que actualmente no (otra cuestión es que ayude a redactar escritos como se verá más adelante), no obstante, hay un caso interesante en EEUU donde se planteó realmente esta posibilidad, os presento la historia de Joshua Browder y la empresa DoNotPay (No pagar).

La historia comienza en el año 2015, cuando un joven emprendedor, llamado Joshua Browder, de 18 años, tras recurrir con éxito multas de tráfico, decidió crear un chatbot legal (un programa que imita el comportamiento humano) llamado DoNotPay (No pagar) para ayudar a recurrir multas de aparcamiento (según Joshua Browder, en una entrevista en la BBC, «Cuando comencé a conducir a los 18 años, comencé a recibir un gran número de multas de estacionamiento y creé el servicio como un proyecto paralelo», dice, «nunca hubiera imaginado que, poco más de un año después, apelaría con éxito a más de 250.000 entradas”. El chatbot se lanzó en marzo de 2016.

Dicho chatbot fue un éxito, Joshua Browder lo describió como «el primer robot abogado del mundo» y se amplió al cálculo de la compensación de vuelos retrasados, también, mientras estudiaba ingeniería en Stanford, y con la ayuda de abogados, decidió crear otro chatbot para ayudar a los refugiados sirios con las solicitudes de asilo, por poner un ejemplo de la BBC, “El robot sugiere formas en que el solicitante de asilo puede responder preguntas para maximizar sus posibilidades de que se acepten las solicitudes, por ejemplo: «La mejor respuesta para su situación incluirá una descripción de cuándo comenzó el maltrato en su país de origen»”. Actualmente también lleva otros temas, como reclamaciones a las compañías de seguros, solicitudes de becas, trámites administrativos etc.,

Al comienzo, la relación con los abogados fue idílica, en enero de 2020, recibió un premio por parte del Colegio de Abogados de EEUU (American Bar Association , ABA) por sus esfuerzos en materia de acceso a la justicia), pero en 2023 estalló el conflicto, dado que Joshua Browder anunció que el 22 de febrero de 2023 tendría lugar el primer juicio en Estados Unidos donde una IA representaría a la defensa de una persona acusada.

Todo ello se haría mediante una argucia legal ofreciendo sus consejos a un abogado humano a través unos los auriculares conectados a un móvil. “»Está dentro de la ley, pero no creo que nadie pudiera haberse imaginado que esto sucedería», ha asegurado Browder a CBS News. «Mucha gente no puede pagar la ayuda legal. Si estos casos tienen éxito, alentará a más tribunales a cambiar sus reglas»”. Browder alegó que se democratizaría el acceso a la justicia, ayudando a obtener representación legal gratuita. La BBC calificó a Browder como el «Robin Hood de Internet». Browder ofreció un millón de dólares al abogado que utilizara dicho chatbot en un juicio.

El chatbot nunca llegó a actuar en el juicio, varios colegios de abogados amenazaron con 6 meses de cárcel a Browder si lleva el chatbot a una sala física. Además, según Confilegal, “La Corte Suprema estadounidense prohíbe expresamente el uso de aparatos electrónicos durante los procedimientos judiciales”. Además, en esa misma noticia, se recoge el testimonio de una abogada donde critica el chatbot por su baja calidad “Tewson indicó que no tenía ningún tipo de «análisis jurídico» y que se trataba de una denuncia «peor que inútil» por una cantidad de errores y descuidos en la redacción”.

A todo esto, hay que añadir, que, en marzo de 2023, el butefe Edelson ha demandado a DoNotPay argumentando que «Desafortunadamente para sus clientes, DoNotPay no es en realidad un robot, un abogado ni un bufete de abogados. DoNotPay no tiene un título en derecho, y no está supervisado por ningún abogado».

Para acabar con esta sección, respecto a la afirmación de que DoNotPay no tiene título en Derecho, según la agencia Reuters, en una noticia de enero de 2023, la Facultad de Derecho de Minnesota (EEUU), hizo un experimento con otra IA, en este caso ChatGPT, calificaron cuatro exámenes finales contestados por ChatGTP a ciegas, junto con exámenes de alumnos reales, el resultado, fue que las calificaciones oscilaron entre el B y el C, según la noticia “ChatGPT aún no puede superar a la mayoría de los estudiantes de derecho en los exámenes, sugiere una nueva investigación, pero puede lograr una calificación aprobatoria” y se añade más tarde que “»Por sí solo, ChatGPT sería un estudiante de derecho bastante mediocre», afirmó el autor principal del estudio, Jonathan Choi, que colaboró con los profesores Kristin Hickman, Amy Monahan y Daniel Schwarcz”. Es decir, la IA es capaz de aprobar algunos exámenes, pero no de superar la carrera.

1.2 El impacto de la IA en el trabajo de los abogados

Aunque como hemos visto, la IA no puede intervenir directamente en un Juzgado o Tribunal, no quiere decir que no pueda ayudar a los abogados en los textos del día a día, incluso a veces puede jugar malas pasadas, según relata Confilegal, en una noticia de mayo de 2023, que a su vez se basa en el periódico The New York Times, “Un abogado de EE.UU se enfrenta a una posible sanción por utilizar en un juicio citas falsas creadas por ChatGPT sin comprobar su veracidad” , el problema fue que la IA se inventó sentencias y el abogado no comprobó la veracidad de la información. Este caso es el primero de este tipo, pero posiblemente, no sea el último, y acabará llegando a España, por lo que, en este sentido, los jueces van a tener que realizar un trabajo extra al verificar la información.

Entrando en el trabajo del día a día, ya hay programas como ChatGTP, MIAbogado, Justicio etc., que crean contratos, demandas, formularios, resumen textos legales, resuelven consultas legales, generan correos electrónicos o respuestas a dichos correos, dan ideas para artículos jurídicos e incluso lo redactan etc., y no me extrañaría que el futuro surgiera una IA que analizara las sentencias de un juez en concreto (obteniendo la información de bases de datos jurídicas por ejemplo CENDOJ), para saber cómo aplica la legislación ante casos concretos, y poder redactar demandas todavía más personalizadas para convencer a un juez concreto de que nuestra postura es la correcta (algo que por otro lado, aunque de forma manual, ya han recomendado algunos profesores en la Facultad de Derecho).

Como veremos más adelante, la Carta ética europea sobre el uso de la inteligencia artificial en los sistemas judiciales y su entorno, aborda el asunto de analizar las sentencias, siguiendo el nombre de los jueces.

En cuanto al impacto en el empleo, según un estudio del Fondo Monetario Internacional ( https://www.imf.org/en/Publications/Staff-Discussion-Notes/Issues/2024/01/14/Gen-AI-Artificial-Intelligence-and-the-Future-of-Work-542379?cid=pr-com-SDNEA2024001 ), y citando el resumen de su página web “En un nuevo análisis, el personal técnico del FMI examina el posible impacto de la IA en el mercado laboral. Muchos estudios han advertido de la probabilidad de que la IA reemplace empleos. Pero en muchos casos, la IA tenderá a complementar el trabajo de los seres humanos. El análisis del FMI considera estas dos fuerzas.

Los hallazgos son notables: casi un 40% del empleo mundial está expuesto a la IA. Históricamente, la automatización y la tecnología de la información han tendido a afectar las tareas rutinarias, pero una de las características que diferencia a la IA es su incidencia en trabajos de alta cualificación. Por lo tanto, la IA acarrea mayores riesgos para las economías avanzadas en comparación con los mercados emergentes y en desarrollo, pero también les presenta más oportunidades para explotar las ventajas.

En las economías avanzadas, alrededor de un 60% de los empleos pueden verse afectados por la IA. Aproximadamente la mitad de los empleos que están expuestos podrían beneficiarse de la integración de la IA, que mejoraría la productividad. En la otra mitad, las aplicaciones de IA pueden ejecutar tareas que en la actualidad son realizadas por seres humanos, lo cual podría reducir la demanda de mano de obra, con una consiguiente merma de los salarios y la contratación. En los casos más extremos, algunos empleos pueden desaparecer”.

Es decir, algunos empleos corren el riesgo de desaparecer, pero en otras ocasiones, la IA simplemente complementa el trabajo, lo cual puede hacer que se reduzca la mano de obra, pero no que desaparezca.

El MIT (Instituto Tecnológico de Massachusetts) también ha publicado un estudio sobre el impacto de la IA en el empleo (https://futuretech-site.s3.us-east-2.amazonaws.com/2024-01-18+Beyond_AI_Exposure.pdf ), citando un resumen del estudio “desde el MIT se modeló el atractivo económico de automatizar diversas tareas (todas centradas en Estados Unidos), concentrándose en trabajos donde se empleaba la visión por equipos informáticos (entre otros, maestros o tasadores de propiedades). Se trataba de cuantificar la cuestión, no solo de si la IA automatizará los trabajos humanos, sino también de cuándo podría suceder esto.

Luego, los investigadores observaron los salarios pagados a los trabajadores que actualmente realizan estos trabajos y calcularon cuánto podría costar incorporar una herramienta automatizada.

Como se explica, un trabajador minorista, por ejemplo, actualmente podría ser responsable de verificar visualmente el inventario o garantizar que los precios listados en una tienda para una mercancía específica sean precisos. Una máquina entrenada en visión por computadora podría técnicamente hacer este trabajo, pero en esta etapa todavía tendría más sentido económico para un empleador pagar a un trabajador humano para que lo haga”.

A su vez, según Neil Thompson, uno de los autores del estudio “En muchos casos, los humanos son la forma más rentable y económicamente más atractiva de trabajar en este momento. Lo que estamos viendo es que, si bien existe un gran potencial para que la IA reemplace tareas, no va a suceder de inmediato. Es realmente importante pensar en la economía de implementar realmente estos sistemas.

Hay una razón por la que la IA no ha estado en todas partes de inmediato. Y hay una razón económica detrás de eso. Y creo que esto debería recordar mucho las cosas que hemos visto con otras tecnologías”.

Lo que viene a decir el MIT es que no es solo que la IA sea capaz de hacer el trabajo de un humano, si no también que lo haga de forma rentable, en mi opinión, los trabajos del FMI y del MIT se complementan, la IA va a ser capaz de realizar muchas de las funciones que realizan actualmente personas, pero de cara al empleo, además tiene que hacerlo de forma rentable y eso marcará la diferencia respecto a cómo afectará a los puestos de trabajo.

Un ejemplo de lo expuesto son los robots camareros, que ya existen desde hace años, pero que en España tienen muy poca implantación (yo no he visto ni uno, solo en alguna noticia en los medios de comunicación), el robot puede tener un servicio de comandas, llevar a la mesa la comida y la bebida etc., sin embargo, la hostelería española sigue prefiriendo al camarero humano, posiblemente porque en el cómputo global, el humano puede realizar más funciones de forma más barata.

Con la abogacía pasa lo mismo, muchas de las empresas prometen ser capaces de redactar demandas y contratos, pero para suplantar a un abogado humano deberán no solo hacerlo, sino también de forma rentable y ello implica un cierto nivel de perfección para poder actuar incluso sin supervisión, además de poder realizar múltiples funciones, también, por ejemplo, puede darse el caso de que afecte parcialmente, y donde antes se necesitan cinco abogados, ahora se necesitarían dos, por lo que es posible que afecte parcialmente al empleo, a lo que hay que añadir que la IA también generará puestos de trabajo a los abogados que trabajen en ese tema, y que por ahora, y no se espera que cambie a corto plazo, la IA no puede intervenir en un juicio ocupando el lugar de un abogado colegiado.

En relación a este tema, últimamente se están vertiendo opiniones en los medios de comunicación, ya sea por parte de periodistas o de dueños de las empresas de la IA, respecto a la abogacía que “su trabajo es ahora inútil” o que gracias a la IA se podrán hacer valer los derechos sin necesitar de conocimientos legales.

Respecto a que la IA es una herramienta para hacer valer los derechos sin conocimientos legales, la cuestión es hasta qué punto la IA es capaz de sustituir al humano.

Por poner un ejemplo de un proceso real, previamente a redactar la demanda hay que hacer un análisis de viabilidad, y es posible que la otra parte se oponga y haya que asistir a sala. En otras ocasiones es contestar a la demanda, donde el usuario tendrá que valorar si la IA es capaz de “desmontar” los argumentos del contrario. Hay que saber el fuero (dónde se presenta), si la IA utiliza legislación española o extranjera, si las sentencias son reales o inventadas, estrategia procesal, plazos etc. Para ganar un juicio muchas veces es cuestión de probar lo que se dice y tener la ley de tu lado (a veces hay inversión de la carga de la prueba, pero hay que saber cuándo).

He visto contestaciones breves pero muy bien fundamentadas, que han ganado juicios, y auténticos ladrillos que pierden por estar mal fundamentados (ej toda la oposición se basa en que es consumidor, y no lo es). Además, hay que cuidado con lo que se aporta como prueba, a veces favorece a la parte contraria.

La IA es una gran herramienta que puede ayudar a la abogacía y hay que estar al día, pero también es necesario un periodismo de calidad, que mire más allá del sensacionalismo y las notas de prensa de los CEO de la empresas de las IA donde se indique cual es el nivel real de desarrollo y como puede ayudar a los abogados, al sistema judicial y a los ciudadanos, desechando la idea de que la abogacía se resume en redactar un papel, e incluso aunque la IA pueda redactar perfectamente una demanda, hay que saber que preguntas hacer, y que datos son relevantes, porque se puede dar el supuesto de que lo que se quiera reclamar haya prescrito, estemos ante una excepción a la ley etc., y el ciudadano debe saber las ventajas e inconvenientes de actuar sin abogado en aquellos casos donde puede, de forma realista, lo cual no quita que está su derecho de actuar como estime oportuno, pero de cara a la tutela judicial efectiva, el ciudadano debe de saber cuál es el límite del programa de la IA, que por otro lado, puede cambiar dependiendo del programa y mejorar con los años, pero actualmente, es más una ayuda que una sustitución.

No obstante, aunque suene paradójico este punto puede ayudar a los abogados, dado que muchos conocen al típico cliente que “sabe más que el abogado” porque lo ha leído en Google, y aunque sea malo para Juzgado porque le sobrecarga de trabajo, más de un ciudadano acabará valorando el trabajo de un profesional tras experimentar por su cuenta. También existe la posibilidad de que aumenten las demandas masivas, ya sea con o sin abogado, al facilitar el trabajo.

Luego está de cómo afecta a los honorarios, si la IA es capaz de disminuir la carga de trabajo de los abogados podrán llevar más casos y es posible que disminuyan los costes (aunque haya que pagar el programa) lo cual por un lado puede aumentar los beneficios, pero por otro puede aparecer algún despacho que baje los honorarios para captar más clientes, precarizando más la abogacía, en especial los pequeños despachos, y luego está la cuestión de que se necesiten menos abogados lo cual también puede afectar negativamente al empleo y al salario si hay un exceso de abogados. No obstante, también puede ocurrir que los abogados adquieran más funciones derivadas de la IA como nuevos nichos legales y luego está la cuestión que para muchos juicios es preceptivo un abogado.

En resumen, desconozco que pasará en el futuro, pero los abogados deben de estar al día con las nuevas tecnologías para adaptarse a los nuevos retos que deparará el futuro.

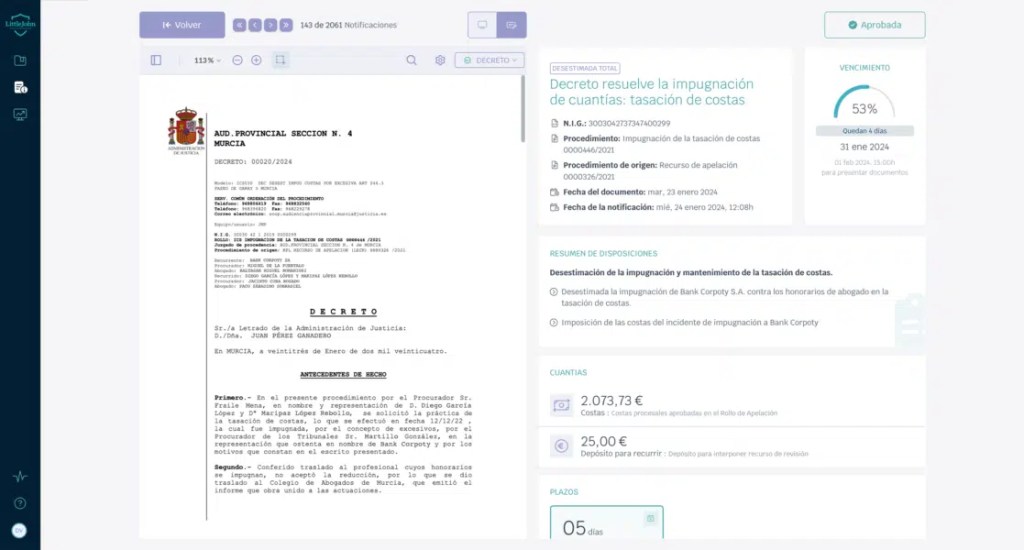

Un ejemplo práctico de todo expuesto, que relata Confilegal, lo podemos ver a IA “Descubrimiento de recompensas” de la empresa española Little John (el escudero de Robin Hood), que es una «Legaltech» (tecnología legal) lanzada por Arriaga Asociados. En esta IA, el usuario puede subir el contrato bancario, y la IA analizará la viabilidad, por ejemplo, de la cláusula suelo, y cuanto se puede obtener, y todo ello sin la intervención de ningún abogado.

En una noticia posterior, también de Confilegal, se dan más detalles sobre Little John. En concreto, se indica que “«El uso de la tecnología junto a la Inteligencia Artificial permite captar clientes y gestionar el despacho de una manera impensable hace poco más de un año», afirma su CEO, Daniel Vecino”.

Más adelante se describe que “Su forma de operar es muy simple. Es un servicio plenamente aplicable a cualquier despacho de abogados o negocio legal. Y en todo tipo de casos, como, por ejemplo, las demandas colectivas.

El potencial cliente, pongamos que tiene dudas sobre su contrato hipotecario, ya sea por cláusulas suelo, IRPH, Euribor, por seguros suscritos o contratos de telefonía, por poner algunos ejemplos, puede recibir, en cuestión de segundos -a través de su teléfono móvil-, un proyecto de dictamen que le dice si su caso es susceptible de ser demandado, o no, y lo que se puede obtener por ello.

No hace falta descargar ninguna aplicación ni instalar nada ni registrarse. La persona en cuestión, a través de una sola pantalla, que además permite el uso del dominio e identidad corporativa de cada despacho, descubre la recompensa económica a la que puede optar capturando con su móvil los documentos clave.

Si la consulta es sobre el IRPH o cláusulas suelo la persona tiene tres opciones: una subir el contrato en pdf desde el móvil, hacer fotos o capturar como quien graba un vídeo de las páginas del contrato y de las facturas.

La tecnología de Little John escanea, digitaliza y analiza el material. En muy pocos segundos lo que obtiene es la lectura de todos los datos principales y el cálculo de lo que podría recuperar.

Por eso la hemos bautizado con el nombre de «Descubrimiento de recompensas” o “Rewards Discovery». Porque el potencial cliente obtiene la recompensa de saber si su caso tiene viabilidad y lo que se podría obtener en los tribunales de justicia.

Es posible que no haya ninguna irregularidad con el IRPH, pero podría haber otros problemas. La inteligencia artificial también detecta y analiza estos, proporcionando un informe a la persona sobre sus opciones si decide presentar una demanda.

La solución también permite enviar archivos de audio con explicaciones o videos, los cuales son procesados por su Inteligencia Artificial. Esta analiza el contenido y proporciona respuestas legales sobre si lo mencionado en una relación laboral o profesional puede ser motivo de demanda y cuáles serían sus posibles consecuencias”.

Adjunto un par de capturas de pantalla de Little John, obtenidas de la noticia:

El periódico Cinco Días (perteneciente a El País), también hizo un reportaje a personas vinculadas a diversos despachos, como Legálitas, Reclamador, Arriaga Asociados, Unive Abogados etc., donde dieron su opinión respecto a las utilidades prácticas, ven la IA como una oportunidad, y lo utilizan para resúmenes, optimizar preguntas, orientar a los clientes con preguntas básicas, poder pasar la consulta jurídica directamente al abogado de la materia sin pasar por un intermediario, estudio de asuntos etc. Todos coinciden en que es un complemento al abogado pero que este no es reemplazable, y en mi opinión bajo la tecnología actual (en el futuro puede pasar de todo) estoy de acuerdo.

A todo esto, hay que añadir, que, el Banco de España, según una noticia que recoge ElPaís ““Cabe esperar que la complementariedad con la robótica y la IA será mayor para aquellos trabajadores que entiendan cómo operan las nuevas tecnologías y sean capaces de proporcionar valor añadido a las tareas realizadas por robots y algoritmos”, explica el informe. “También se verán en mayor medida favorecidos aquellos trabajadores lo suficientemente versátiles como para realizar varias tareas diferentes y horizontales en el proceso de producción de bienes y servicios. Por el contrario, aquellos que se limitan a la realización de un número reducido de tareas —rutinarias o no, manuales o no manuales— serán, previsiblemente, desplazados por las nuevas tecnologías”, añade. “En cualquier caso, la digitalización y los avances en IA también podrían favorecer las oportunidades de empleo para los trabajadores de menor cualificación profesional y habilitar instrumentos que complementen sus habilidades”, concluye”.

Es decir, según el Banco de España aquellos trabajos rutinarios, son aquellos que corren más riesgo de ser desplazados por las nuevas tecnologías. Esto se puede trasladar al ámbito de la abogacía, de hecho, algunos despachos ya están implantando programas de inteligencia artificial que detecta de forma automática las cláusulas abusivas en las hipotecas, y, por lo tanto, que se puede reclamar, y por cuánto.

En ese sentido, las áreas jurídicas de los “pleitos en masa”, probablemente se verán más afectados por la IA (lo cual puede afectar al empleo, al ser el porcentaje del trabajo del abogado que realiza la IA mayor), que áreas jurídicas con pleitos más complejos y “personalizados”, donde el trabajo diario del abogado se verá menos afectado. Esto ofrece una ventana de oportunidad a aquellos despachos que sepan utilizar la IA o puedan costearse una IA para los pleitos en masa, a la vez, que es posible que sean necesarios menos abogados para realizar el trabajo.

Otro artículo interesante en relación al uso de la IA en el trabajo de los abogados, lo encontramos en el periódico ElConfidencialDigital, donde entrevistan a varios abogados.

La noticia comienza diciendo que “El socio director de Ecija Abogados y profesor de universidad Alejandro Touriño ha afirmado que hoy en día esta tecnología permite «automatizar y hacer más eficientes determinados procesos que son puro servicio jurídico». Eso incluye la redacción de contratos, la revisión de documentación, las herramientas de traducción y, sobre todo, la resolución de consultas legales”.

Más adelante se explica el uso por parte de Jesús Ruiz Ballesteros, director y fundador de la firma Ruiz Ballesteros, en concreto se indica que “En su caso, ha explicado que usan Chat GPT para hacer presentaciones, escribir artículos o incluso pedirle que genere frases para las redes sociales del despacho, lo que les permite ahorrar en personal”.

También se aborda la cuestión de automatizar consultas, en concreto, se indica que “Uno de los usos más extendidos de la inteligencia artificial en el ámbito jurídico es la automatización de respuestas a consultas habituales. Ruiz ha asegurado que reciben muchas preguntas de clientes que son similares y a través de herramientas como Chat GPT se pueden estandarizar las soluciones.

Pablo Martínez, director y fundador de G&C Abogados, ha explicado que en su despacho utilizan, además de Chat GPT, la inteligencia artificial desarrollada por el Colegio de Abogados de Madrid para confeccionar documentos.

Esta herramienta analiza lo que el abogado está escribiendo y proporciona al mismo tiempo mensajes con referencias a sentencias del Tribunal Supremo o borradores que se encuentren en la base de datos interna del negocio y que previamente se han anexado a la tecnología.

En cuando a las sentencias, desconozco la fiabilidad de esa IA en concreto, pero se han dado casos de IA que se inventan sentencias, y en cuanto a la IA del ICAM (Ilustre Colegio de la Abogacía de Madrid), si bien, he encontrado una noticia de 2022 donde el ICAM, gracias a una colaboración con Tirant Lo Blanch ofrece de forma gratuita las IA “Tirant Analytics” y “Sof-IA”, actualmente, aunque el ICAM sigue colaborando con Tirant lo Blanch, ese servicio en concreto, es de pago.

A continuación, se indica que “Lo que se busca con estas herramientas es que tu trabajo sea más ágil a la hora de confeccionar los documentos, si lo medimos en tiempo, estas cuatro horas que tardabas puedes reducirlas a tres y a dos”, ha argumentado”.

No obstante, en la noticia se recuerda que lo que redacta la IA son borradores, el abogado tiene que darle instrucciones a la IA usando sus conocimientos legales, y que es importante revisar los documentos, al tiempo que se advierte del mal uso de la IA por parte de clientes, que redactan borradores con ChatGTP y no tienen en cuenta de que cada caso es un mundo diferente, por eso, los abogados no temen que la IA vaya a sustituir el trabajo de los abogados.

En la noticia, también se alerta de la confidencialidad, en concreto, se explica que “Una de las grandes obligaciones que tiene un despacho como Ecija a la hora de asesorar a grandes corporaciones es garantizar la privacidad, confidencialidad y que no hayan brechas de seguridad en sus comunicaciones.

Por tanto, Chat GPT no es apto para estos casos, pues la naturaleza de este robot es reutilizar toda la información que uno le proporciona para futuras consultas de terceros”.

Por último, al margen de ChatGTP, también se menciona Copilot, la IA de Microsoft, en concreto, se expone que “En cambio, Touriño ha explicado que el sistema al que están habituados en su despacho es Copilot, de Microsoft. Con esta inteligencia artificial generan los primeros borradores de una demanda o un contrato y analizan la documentación que les proporcionan las compañías”.

A esto hay que agregar, que, tanto ChatGTP como Copilot, y otras aplicaciones de IA como Microsoft Designer, también sirven para generar imágenes, lo cual es útil para exposiciones, artículos jurídicos, redes sociales etc. En cuanto a aplicaciones para generar vídeos, hay que destacar MiniMax, que forma parte de la plataforma Hailuo AI.

Respecto al uso de ChatGTP por parte de los abogados, según el periódico Hoy Aragón, que cita el estudio “Generative AI & the Legal Profession 2023 de LexisNexis”, hay que destacar que “El principal uso que los abogados le dan a ChatGPT es investigación y documentación (60%) y redacción de documentos (casi 50%). Alrededor del 40% lo utiliza para redactar correos electrónicos y un cuarto lo usa para comprender conceptos legales, como Wikipedia jurídica. Incluso hay quienes diseñan estrategias procesales con la ayuda de la inteligencia artificial. Otras aplicaciones incluyen el análisis de documentos y la realización de due diligences”.

Para concluir este apartado, voy a hacer un resumen con tipos de IA, según su accesibilidad, y aplicaciones de la IA por parte de los despachos de abogados.

En cuanto a los tipos de IA según su accesibilidad, hay que distinguir tres tipos:

- En primer lugar, nos encontramos ante sistemas de IA privadas y propias de despachos de abogados, que, si bien son muy potentes, son probablemente caras, dado que hay que desarrollarlas, y de uso exclusivo por el despacho de abogados que a contribuido a su creación, ya sea de forma directa, a través de la interacción con los clientes.

- En segundo lugar, nos encontramos ante sistemas de IA libres, pero de pago, es, decir, donde puede acceder cualquier despacho, pero pagando.

- En tercer lugar, nos encontramos ante sistemas de IA libres y gratuitas, es decir, donde puede acceder cualquier despacho, de forma gratuita.

Respecto a las aplicaciones de la IA por parte de los despachos de abogados, me voy a basar en todo lo expuesto a lo largo de este apartado y en la exposición del abogado y profesor, Eduardo López Román, en el “II Congreso Iberoamericano de Derechos Digitales”, del cual os dejo el enlace ( https://www.youtube.com/watch?v=Vlzeb4N0edw ).

“Ejemplos de casos de usos en los despachos:

- Atención al cliente automatizada

- Generación de documentos legales

- Análisis y resumen de documentos

- Asesoramiento legal instantáneo

Ejemplos de cómo puede ayudar en el análisis de resoluciones, jurisprudencia y leyes:

- Resúmenes automáticos

- Análisis comparativo

- Búsqueda de precedentes

- Análisis de argumentos legales

Ejemplos de preguntas legales comunes que se pueden responder rápidamente:

- Interpretación de términos legales

- Procedimientos legales

- Derechos del consumidor

- Legislación vigente”

A todo esto, hay que añadir lo expuesto a lo largo del trabajo, como generar borradores de contratos y demandas, detectar cláusulas abusivas en hipotecas, y por lo tanto, saber cuándo es reclamable y por qué cuantía, hacer resúmenes, estudio de asuntos, automatizar tareas, herramientas de traducción, automatizar respuestas a consultas habituales, usos en redes sociales, generar imágenes, analizar sentencias, generar correos electrónicos o respuestas a dichos correos, transcripción de voz y de vídeos etc. También se pueden crear asistentes personalizados.

Para para la transcripción de archivos de audio y vídeo a texto, hay que resaltar la IA “Sonix”, como ejemplo de ello, o la IA “Sora”, de OpenAI, y para el dictado de voz jurídico, es decir, para la transcripción de voz, hay que destacar la IA “DigaLaw X”, que además también hace funciones de traducción automática.

Hay que mencionar, que están apareciendo buscadores que utilizan IA, como alternativa a buscadores tradicionales como “Google Chrome”, que ya están utilizando algunos despachos, un ejemplo de ello, es el motor de búsqueda “Perplexity”.

Citando la respuesta que proporciona “Perplexity”, “mientras Perplexity AI se destaca por su capacidad de búsqueda y precisión en tiempo real, ChatGPT es más adecuado para conversaciones naturales y creativas. Ambos tienen sus fortalezas y son utilizados en función de las necesidades específicas del usuario”.

Por último, es importante verificar la información, según una noticia de “Diario de Navarra”, de 12 de noviembre de 2024, “El uso de la Inteligencia Artificial está cada vez más presente en todos los ámbitos de la vida. Pero un empleo sin supervisión puede traer problemas. Es lo que le ocurrió a un abogado navarro que utilizó Chat GPT para elaborar una querella y la herramienta le incluyó entre la jurisprudencia una cita del Tribunal Supremo que hacía referencia a un artículo del Código Penal… pero de Colombia. El error fue advertido por la Sala de lo Civil y Penal de Tribunal Superior de Justicia de Navarra, que decidió abrir una pieza separada al letrado por posible mala fe procesal. Al final, el asunto se ha archivado por lo “novedoso de la materia” y las disculpas inmediatas que presentó el abogado”.

En la noticia se añade que “los magistrados destacan que un estudio de enero de 2024 concluyó que las “alucinaciones jurídicas” (errores) eran “alarmantemente prevalentes” en Chat GPT”.

No obstante, “El TSJN ha decidido no imponer ninguna sanción al abogado. Lo basa en “la singularidad del caso, el hecho de que se trate de una materia ciertamente novedosa, así como la inmediata reacción del letrado querellante excusando el error cometido”. Eso sí, los magistrados entienden que el caso puede servir de “advertencia de las implicaciones legales, deontológicas y éticas que puede plantear el uso descuidado de las nuevas tecnologías”.

2. El impacto en la Administración de Justicia

2.1 Guía del Poder Judicial de Inglaterra y Gales sobre el uso de la IA por parte de los cargos judiciales

El 12 de diciembre de 2023 el Poder Judicial de Inglaterra y Gales ha publicado una guía sobre el uso de la IA por parte de los titulares de cargos judiciales, que se puede consultar a través de este enlace (https://www.judiciary.uk/wp-content/uploads/2023/12/AI-Judicial-Guidance.pdf ). En palabra de la presidenta del Tribunal Supremo de Inglaterra y Gales “esta guía ha sido elaborada por un grupo judicial interjurisdiccional para ayudar al poder judicial, sus secretarios y otro personal de apoyo en el uso de la IA”.

Haciendo un resumen del documento, la guía establece los usos potenciales de la IA junto con sus problemas y riesgos. Entre los problemas y riesgos de la IA se encuentra la privacidad y la necesidad de verificar la información (que puede ser inexacta, incompleta, engañosa o desactualizada).

Entre los usos potenciales de la IA se encuentran resumir grandes volúmenes de textos, escribir presentaciones, sugerencias sobre temas a cubrir, y realizar tareas administrativas como redactar correos administrativos y memorandos.

La IA no se recomienda para la investigación jurídica, verificar información y el análisis jurídico, citando la guía «the current public AI chatbots do not produce convincing analysis or reasoning» (los actuales chatbots públicos de IA no producen análisis ni razonamientos convincentes).

También se incluyen una serie de trucos para detectar si un texto jurídico está escrito por la IA (citas desconocidas, ortografía de EEUU, texto muy persuasivo pero que cuando profundizas tiene errores obvios etc.).

Esta guía de ocho páginas, tiene múltiples usos, le puede servir tanto a la Administración como a los operadores jurídicos, como los abogados, para un mejor uso de la IA, siendo consciente de sus virtudes y defectos, y también en otros ámbitos, como la docencia y los concursos jurídicos (además de la propia Administración) dado que se indican consejos para detectar si un texto jurídico está escrito por la IA, y así evitar el fraude.

2.2 El uso de la IA en el sistema judicial alemán

En cuanto al uso de la IA en el derecho comparado, vamos a comenzar por Alemania, donde nos encontramos con un par de ejemplos interesantes. Tal y como se relata en una noticia de IMB, los Tribunales alemanes se están teniendo problemas debido a la sobrecarga de trabajo. En el Tribunal Regional Superior de Stuttgart, llegó a haber un retraso de más de 10.000 casos.

Para solucionar este problema “El Ministerio de Justicia de Baden-Württemberg recomendó utilizar IA con comprensión del lenguaje natural (NLU) y otras capacidades para ayudar a categorizar cada caso en los diferentes grupos de casos que estaban manejando”. Es por ello que IMB creó una IA llamada OLGA “que ofrecía categorización de casos, extraía metadatos y podía ayudar a que los casos tuvieran una resolución más rápida. Con OLGA, los jueces y secretarios pueden examinar miles de documentos más rápidamente y utilizar criterios de búsqueda específicos para encontrar información relevante en diversos documentos. Además, el sistema proporcionaría información sobre la demanda para contextualizar la información que surgiera de la búsqueda. El algoritmo conservó el historial del caso y brindó a los usuarios una vista completa de toda la información del caso y dónde se originó”. Gracias a esta medida se disminuyó la carga de trabajo y los Tribunales informaron que se prevé que el tiempo de procesamiento de datos se pueda recudir en más de un 50%.

Otro ejemplo del uso de la IA se encuentra en el Tribunal de Distrito de Frankfurt. Tal y como se relata en la noticia, “IBM trabajó con el Tribunal de Distrito de Frankfurt para probar con éxito un sistema de inteligencia artificial conocido como “Frauke” (Frankfurt Judgment Configurator Electronic) para demandas sobre los derechos de los pasajeros aéreos. Cada año llegan al Tribunal de Distrito de Frankfurt entre 10.000 y 15.000 casos relacionados con los derechos de los pasajeros (por ejemplo, relacionados con retrasos). El tribunal pidió ayuda para el proceso de redacción de las sentencias. Esta fue una tarea muy laboriosa y repetitiva para los jueces, que tuvieron que recopilar los datos relevantes y, al final, redactar repetidamente sentencias casi idénticas”.

En cuanto al uso de la IA “Frauke” se destaca que “En una prueba de concepto el año pasado, Frauke extrajo los datos individuales del caso (incluido el número de vuelo y el tiempo de retraso) de los alegatos y, de acuerdo con el veredicto del juez, ayudó a acelerar la redacción de cartas de sentencia utilizando texto escrito previamente. módulos. Hasta ahora, mediante el uso de esta tecnología, Frauke ha podido reducir significativamente el tiempo de procesamiento en la preparación de sentencias”.

2.3 El uso de la IA en el sistema judicial de China

Otro ejemplo interesante del uso de la IA en el sistema judicial es el caso de China. Recientemente han salido noticias llamativas sobre “jueces robot”, aunque una vez que se profunda en la cuestión, se descubre que son titulares muy sensacionalistas, y que más bien son “asistentes robóticos”. La fuente original se encuentra en la página web de “Beijing Internet Court” (Tribunal de Internet de Beijing (Pekín)), titulado “Tribunal de Internet de Beijing inaugura centro de servicios de litigios en línea” (https://english.bjinternetcourt.gov.cn/2019-07/01/c_190.htm ).

La nota de presa comienza diciendo que “El 27 de junio (de 2019), el Tribunal de Internet de Beijing inauguró un centro de servicios de litigios en línea, que incluye un juez de inteligencia artificial, un microtribunal móvil y la cuenta oficial del tribunal de Weitao, un servicio de microblogging para marcas”.

Respecto a ese “juez” se destaca que es “el primero de su tipo en el mundo”. Añadiendo que “La jueza tiene una imagen femenina con voz, expresiones faciales y acciones basadas en una persona real, uno de los jueces del tribunal”. También se incluye una imagen de la presentación de la “jueza” que adjunto a continuación.

Sin embargo, una vez que seguimos leyendo la noticia, nos damos cuenta que en la práctica, no es un “juez robot” sino un “asistente robot”, citando la noticia, se menciona que “Basado en tecnologías inteligentes de síntesis de voz e imágenes, el juez de IA ayudará a los jueces del tribunal a completar el trabajo básico repetitivo, incluida la recepción de litigios, permitiendo así a los profesionales centrarse mejor en su trabajo judicial”.

Como curiosidad, en la nota de prensa, también se menciona un “microtribunal móvil” que “permite gestionar la presentación, la mediación, la audiencia judicial, la asistencia a la audiencia judicial y las consultas a través de teléfonos móviles”.

Otro ejemplo del uso de la IA por parte de China es el programa “Xiao Zhi 3.0“ («Pequeña Sabiduría»), que una vez más, es un asistente jurídico robot, y que permite liberar trabajo a los jueces. Según la noticia, “China está utilizando Xiao Zhi 3.0 («Pequeña Sabiduría») para ayudar en la toma de decisiones legales en procedimientos civiles. Implementado por primera vez en Hangzhou en 2019, facilitó un juicio de 10 personas que no podían pagar sus préstamos bancarios. Ahora se utiliza en disputas financieras simples, analizando materiales de casos, verificando información de bases de datos y registrando testimonios. La implementación de Xiao Zhi 3.0 en el sistema legal de China lo ha hecho más rápido y eficiente; Ahora se pueden ver 10 juicios separados en una sola audiencia de 30 minutos ante un solo juez”.

Por último, hay que destacar una noticia relacionada con China y la IA que tuvo cierta repercusión en la prensa española. El 3 de enero de 2022, el periódico Confilegal publicó una noticia titulada “China inventa «un fiscal» de Inteligencia Artificial capaz de presentar cargos con un 97 % de precisión” (https://confilegal.com/20220103-china-inventa-un-fiscal-de-inteligencia-artificial-capaz-de-presentar-cargos-con-un-97-de-precision/ ).

Citando el periódico “La Fiscalía Popular de Shanghai Pudong, la mayor fiscalía de distrito de China, ha implementado un sistema informático basado en Inteligencia Artificial (IA) capaz de elaborar escritos de acusación y presentar cargos contra sospechosos basándose únicamente en una descripción verbal, según ha publicado el South China Morning Post (SCMP).

Dichos escritos de acusación pueden tener una precisión superior de hasta el 97 % a partir de una descripción verbal de lo sucedido en cada caso.

Esta tecnología podría contribuir a reducir la carga de trabajo diaria de los fiscales, permitiéndoles centrarse en las tareas más difíciles y complicadas, de acuerdo con el profesor Shi Yong, científico principal del proyecto y director del laboratorio de «big data» y gestión del conocimiento de la Academia China de Ciencias”.

Pero ¿qué hay de cierto en esta noticia?, ¿hay una sección de la fiscalía china, dirigida por la IA que elabora escritos y presenta cargos?, es lo que se va a analizar a continuación.

La noticia original se publicó el 26 de diciembre de 2021, en el periódico South China Morning Post, con el título “Científicos chinos desarrollan un ‘fiscal’ de IA que puede presentar sus propios cargos”. Dicha noticia es de pago, pero en lo que se puede leer de forma gratuita, se indica que “Hasta el momento, la máquina es capaz de identificar ocho delitos comunes, como fraude, apuestas, conducción peligrosa y «buscar peleas», según los investigadores” y que “Los fiscales en China ya utilizan una herramienta de inteligencia artificial para evaluar pruebas y determinar qué tan peligroso es un sospechoso para el público”.

Por lo tanto, se da a entender, que es más una herramienta que una IA autónoma. No obstante, la web Tech Wire Asia ofrece más información.

En la web se indica que “los científicos chinos han desarrollado un “fiscal” de inteligencia artificial que puede acusar a las personas de delitos. Fue desarrollado por un equipo dirigido por el profesor Shi Yong, director del laboratorio de gestión del conocimiento y big data de la Academia China de Ciencias.

El profesor Shi afirma que la máquina es capaz de presentar un cargo con una enorme precisión del 97% basándose en una descripción verbal del caso.

En teoría, la máquina podría reducir la carga de trabajo de los fiscales, para que puedan centrar su tiempo y esfuerzos en tareas más difíciles.

“El sistema puede reemplazar a los fiscales en el proceso de toma de decisiones hasta cierto punto”, dijeron Shi y sus colegas en un artículo publicado en diciembre en la revista nacional Management Review, revisada por pares.

Sabemos que suena como si un juez androide equipado con una peluca y una túnica estuviera golpeando un mazo y pidiendo silencio en la sala del tribunal, pero en realidad no es así como funciona: en realidad es solo una máquina de inteligencia artificial en una computadora de escritorio, procesando casos”.

Por lo tanto, ese supuesto “fiscal” es una herramienta de IA que ayuda a los fiscales a la hora de redactar escritos de acusación y presentar cargos, y que, según la opinión de sus creadores “El sistema puede reemplazar a los fiscales en el proceso de toma de decisiones hasta cierto punto”, que es distinto a que el gobierno chino utilice fiscales de IA que funciones de forma autónoma. De hecho, desde la publicación de esta noticia, no se ha vuelto a saber más de este asunto, por lo que entiendo que esa IA no deja de ser una herramienta controladas por humanos, y los fiscales siguen siendo humanos.

No obstante, la noticia de Tech Wire Asia no acaba aquí. Se menciona que China empezó a utilizar la IA en el sistema judicial en el año 2016 a través de la herramienta System 206 (citando a su vez, la noticia ya comentada del periódico South China Morning Post).

Se destaca que “El Sistema 206 puede evaluar la solidez de las pruebas, las condiciones de los arrestos y el nivel de peligro de un sospechoso para la sociedad.

Sin embargo, las limitaciones de las herramientas de inteligencia artificial existentes, como el Sistema 206, eran que no estaban diseñadas para ser parte del proceso de toma de decisiones para presentar cargos y sugerir sentencias, según Shi” (Shi es el mismo creador de la misma IA que ayuda a la fiscalía china).

Por último, hay que añadir que en la noticia se señala que el primer país que utilizó la IA para dictar sentencias fue Malasia en febrero de 2020, y se indica que “Actualmente, el sistema de inteligencia artificial del poder judicial de Malasia Oriental se utiliza para delitos como posesión de drogas y violación”.

2.4 La primera sentencia del mundo con ayuda de la IA, en Malasia

Respecto a la utilización de la IA para dictar sentencia en Malasia en febrero de 2020, Tech Wire Asia añade un enlace al periódico New Straits Times, que es un periódico en inglés que publica en Malasia, donde se relata dicha noticia (https://www.nst.com.my/news/nation/2020/02/567024/malaysian-judiciary-makes-history-uses-ai-sentencing ).

Como relaté en el apartado anterior sobre China, Tech Wire Asia, citando esta noticia de periódico New Straits Times, titulada “El poder judicial de Malasia hace historia y utiliza la IA para dictar sentencias” indica que Malasia fue el primer país que utilizó la IA para dictar sentencias, en febrero de 2020, y se añade que “Actualmente, el sistema de inteligencia artificial del poder judicial de Malasia Oriental se utiliza para delitos como posesión de drogas y violación”. Hay que aclarar que es un juez que utiliza la IA como ayuda a la sentencia, no que la IA dicte sentencia de forma autónoma, que es distinto.

Citando la noticia “El poder judicial de Malasia hizo historia hoy al emplear Inteligencia Artificial (IA) al dictar sentencias en dos casos de drogas, pero no sin la objeción de la defensa.

La IA había recomendado 10 meses de cárcel a Denis y 9 meses de cárcel a Christopher después de que se ingresaran en el sistema parámetros como las secciones bajo las cuales se les acusa, la edad, el empleo y los datos socioeconómicos.

Durante el proceso judicial, el juez principal de Sabah y Sarawak, Tan Sri David Wong, estuvo presente en el tribunal.

Más tarde, en una conferencia de prensa, Wong dijo que estaba satisfecho con el proceso y que esperaba que se presentaran objeciones contra el uso de la IA en el sistema judicial.

“Cuando lo lanzamos, esperábamos que fuera cuestionado, pero tenemos que aceptarlo como viene.

“Los abogados tienen derecho a presentar objeciones. (La IA) es una nueva herramienta para la corte. A menos que se pruebe en los tribunales, no sabremos si es constitucional o no”, afirmó.

Wong dijo que aquellos acusados también tendrán la oportunidad de cambiar su declaración, al ser informados sobre las posibles sentencias mostradas por IA antes de que el juez tome una decisión.

También dijo que la IA, que se utilizaría en los tribunales de Sabah y Sarawak, ayudaría a ahorrar tiempo al juez al referirse manualmente a casos pasados. Se espera que el sistema proporcione análisis mejorados y recomendaciones consistentes.

A partir de ahora, el sistema de IA se utiliza para casos de posesión de drogas según el artículo 12 de la Ley de Drogas Peligrosas y violación según el artículo 376 del Código Penal.

“Estamos en el proceso de hacerlo para casos civiles relacionados con accidentes automovilísticos sobre la concesión de daños y perjuicios por lesiones, con suerte en tres a seis meses.

“Es una herramienta útil para el poder judicial. Antes de ir a juicio, ambas partes podrán conocer la indemnización por daños y perjuicios, por lo que los abogados podrán negociar para llegar a acuerdos antes de acudir a los tribunales””.

2.5 El uso de ChatGPT para dictar sentencia en Brasil (presuntamente) y Países Bajos

Si anteriormente vimos el caso de un abogado de EEUU se enfrenta a una posible sanción por utilizar en un juicio citas falsas creadas por ChatGPT sin comprobar su veracidad, ahora nos encontramos con el caso de que “investigan si un juez brasileño usó a ChatGPT para redactar una sentencia, y la publicó con errores”.

Citando la noticia del periódico La Nación, se menciona que “Las autoridades brasileñas abrieron una investigación a un juez federal por usar una herramienta de inteligencia artificial que se equivocó en la redacción de una sentencia, en lo que sería la primera decisión de este tipo en Brasil. El Consejo Nacional de Justicia (CNJ), órgano encargado de mejorar el sistema judicial, pidió al juez Jefferson Rodrigues que explique la publicación de una decisión que contenía fragmentos erróneos formulados por la herramienta ChatGPT”.

El problema del presunto uso de ChatGPT, es que se inventaba la jurisprudencia o como mínimo, la citaba erróneamente. Tal y como relata la sentencia “Según el documento, el magistrado alegó que la decisión redactada con la ayuda de inteligencia artificial (IA) fue elaborada por un “asesor de confianza”. “Las disconformidades ocurrieron debido a la utilización de alguna herramienta virtual que se mostró inadecuada”, se defendió el magistrado”.

Por su parte, el juez niega que haya utilizado ChatGPT y alega que es un “mero equívoco” ocasionado por la “sobrecarga de trabajo”. El concreto, según la noticia, “Rodrigues calificó la situación de “un mero equívoco” originado en la “frecuente sobrecarga de trabajo que recae sobre los hombros de los jueces”. El magistrado dijo además que el autor del equívoco fue un asesor “experimentado” de su gabinete, por lo que no vio necesidad de “revisar” cada una de las jurisprudencias citadas erróneamente”.

En los Países Bajos, se ha documentado el caso de un juez que ha utilizado ChatGPT para recopilar información que posteriormente usó en la sentencia, y que ha generado una gran controversia. En la fuente original, a la que he podido acceder, proveniente “de Rechtspraak” (El Poder Judicial), y cuya sentencia adjunto en este enlace (https://uitspraken.rechtspraak.nl/details?id=ECLI:NL:RBGEL:2024:3636&showbutton=true&keyword=chatgpt&idx=1 ), se menciona que el juez del Tribunal de Distrito de Güeldres, en la sentencia de 26 de julio de 2024 (número de caso 10664071 CV23-2321), utilizó ChatGTP para estimar la vida media de unos paneles solares, citando la sentencia,

“El juez del tribunal regional, en parte con la ayuda de ChatGPT , estima la vida media de los paneles solares desde 2009 entre 25 y 30 años; por lo tanto, esa esperanza de vida se fija aquí en 27,5 años. A estos paneles todavía les quedaban unos 15 años en 2022 5 . Durante el tiempo restante, hay una pérdida de eficiencia máxima (porque probablemente decreciente) de 7,5 mWh. Suponiendo, también en parte basándose en ChatGPT , un precio medio actual del kWh de 0,30 € (de 0,29 € a 0,34 €, dependiendo del tipo de contrato, pero [el demandante en el convenio] no dice nada al respecto) 6 , la pérdida de eficiencia, con un precio del kWh más o menos invariable, asciende aproximadamente a 2.250 €. Por qué no se incluye la cantidad de 13.963,20 € mencionada por [demandante en el convenio] está suficientemente justificado por lo anterior y las notas 4 a 7. 7”

En relación con la vida media de los paneles solares, también se añade que “[El demandante en el convenio] asume una vida útil restante de 20 años, pero esto no está suficientemente fundamentado”. Es decir, el demandante asume una vida útil restante del panel solar en 20 años, pero el juez considera que no está suficientemente probado y le convence más sus investigaciones con ChatGTP por lo que estima una esperanza de vida de 15 años (y no explica cómo fueron las investigaciones).

Más adelante, el juez volvió a usar ChatGTP, citando la sentencia “También se ha establecido que [el demandante en la demanda] luego arrancó el aislamiento y también arrojó varios paquetes de material aislante, que terminaron en el agua, por lo que fue condenado penalmente. Se puede suponer razonablemente (y también basándose en ChatGPT ) que este material ya no era utilizable. Por lo tanto, [el demandante en la demanda] debe reembolsar los costes de reposición de 204,66 euros”. Resumiendo, el material no era utilizable basándose en ChatGPT, y el demandante debe reembolsar los costes de reposición.

Este uso de ChatGTP trae varios problemas si se hiciera en España. En primer lugar, habría que seguir la carga de la prueba del artículo 217 de la Ley de Enjuiciamiento Civil, o si es posible, pedir un informe pericial. En la sentencia tampoco se menciona que las partes hayan podido acceder y valorar la respuesta de ChatGTP, y ChatGTP, a día de hoy no tiene el mismo valor que un informe pericial (y la persona que introduce los datos tampoco es un perito).

A todo esto, hay que añadir, ¿cómo se recurre el informe de ChatGTP, cuando no consta por escrito en ningún lado ni la respuesta al Juez ni las fuentes que ha utilizado ChatGTP para llegar a esa conclusión?

Es por eso que, en España, es necesario que haya unas pautas como la Guía sobre el uso de la IA por parte de los titulares de cargos judiciales elaborada por el Poder Judicial de Inglaterra y Gales o la sentencia T-323 de 2024, de la Corte Constitucional de Colombia que también aborda este asunto, y del que se hablará más adelante. Además, el Reglamento de Inteligencia Artificial de la Unión Europea no regula esta cuestión tan concreta.

Por último, hay que añadir, que tal y como menciona Legal IT Insider “El juez holandés no es en absoluto el primero en utilizar ChatGPT en una sentencia (en relación a la sentencia antes mencionada). El juez del Tribunal de Apelaciones del Reino Unido, Lord Justice Birss, utilizó ChatGPT en febrero del año pasado (2023) para proporcionar un resumen de un área del derecho, describiendo el chatbot como «muy útil»”.

2.6 Proyectos para aplicar la IA en el sistema judicial español

En cuanto a los proyectos para aplicar la IA en el sistema judicial español, hay que destacar el estudio del Centro de Estudios Jurídicos (CEJ) elaborado por la letrada de la Administración de Justicia Cristina Lorenzo Pérez y titulado “Inteligencia artificial en la Administración de Justicia: regulación española y marco europeo e internacional. Proyectos desarrollados por el Ministerio de Justicia” publicado en marzo de 2022, que se puede ver a través de este enlace (https://www.cej-mjusticia.es/sede/publicaciones/ver/13637 ). Algunos de estos proyectos ya están implementados.

En dicho estudio se incluye un apartado de “proyectos y casos de uso del Ministerio de Justicia de España basados en Inteligencia Artificial” que son los siguientes:

1º Clasificación automática de documentos. Se está entrenando un modelo con lenguaje jurídico con una técnica basada en redes neuronales para procesamiento de lenguaje natural con lenguaje jurídico. Este sistema está pensado para utilizarse en sistemas de gestión procesal y/o Lexnet.

2º Extracción de entidades nominales. A destacar que “Mediante esta aplicación podremos, por ejemplo, extraer los domicilios donde se practican lanzamientos en caso de procedimientos civiles y penales, a fin de determinar zonas comunes donde se producen mayor número de casos de ocupación ilegal de inmuebles. Esta información será muy útil de cara a aplicar medidas de refuerzo policial o judicial”.

3º Anonimizador documental. Es relevante que “El principal objetivo del anonimizador documental del Ministerio de Justicia es obtener documentos que, sin pérdidas en el sentido en el contenido, no aporten información personal de los sujetos mencionados, empleando para ello alguno de los métodos de sustitución previstos”.

4º Calculadora 998. Esta calculadora es una “Solución que devuelve el resultado más favorable para el reo en una acumulación de condenas”, se puede acceder a través del siguiente enlace ( https://www.administraciondejusticia.gob.es/-/soluciones-calculadora-988 ).

5º Cancelación automática de antecedentes penales. A destacar que “desde septiembre de 2020, mediante técnicas de robotización, se ha producido a la cancelación automática de oficio de los antecedentes penales de hasta 150.000 ciudadanos en una sola semana, que cumplían los requisitos del art. 136 del Código Penal y sin necesidad de solicitud previa”.

6º Personas con discapacidad. Citando el estudio, esto consiste en que “Dado que los interesados, tutores o fiscalía pueden iniciar dicho proceso de revisión, este canal de entrada se integra y se automatiza hasta la solicitud al Médico Forense (Institutos de Medicina Legal) de su preceptivo informe médico, el cual será remitido por un nuevo canal de entrada al órgano judicial. En este canal un nuevo robot detectará estos casos no susceptibles de mejoría, y realizará todos los trámites de manera automatizada, hasta la elaboración del borrador de la resolución que será puesta a disposición, para su última decisión, al Juez”.

7º Textualización de vistas. Según el estudio “Esta herramienta permite la generación automática del texto tomando como origen las grabaciones realizadas durante las vistas y declaraciones, permitiendo el desarrollo de nuevos servicios y funcionalidades”. Ofrece un promedio de acierto de hasta un 93%.

8º Dictado de voz jurídico. Se trata del sistema de transcripción de voz jurídico “DigaLaw”, que sustituye al programa “Dragón” y que cuenta con un 99% de porcentaje medio de acierto. Actualmente, dicho sistema se llama “DigaLaw X”, y según su página web, ofrece “Reconocimiento de voz ultra preciso (99%) con IA, Traducción y Textualización de vídeos”.

9º Buscador 360. A destacar que “Se está desarrollando un buscador documental avanzado que incluya funciones de búsqueda semántica. A través este sistema se podrán hacer búsquedas mediante escritura o lenguaje natural en todos los documentos del sistema de gestión procesal, incluso en los archivados, de tal manera que podríamos prescindir de guardar “modelos de resoluciones”, o que se facilitarán las búsquedas relacionadas de unas resoluciones con otras”.

10º Biometría como sistema de personación. Según el estudio “Se trata de un sistema para dotar a los órganos judiciales de unos sistemas de identificación automática y autónoma a través de sistemas biométricos. De esta manera se podrá identificar inequívocamente a aquellas personas que tengan que personarse y comparecer en las Sedes Judiciales. Un ejemplo claro de esto sería el cumplimiento de una medida cautelar penal”.

11º Notificación proactiva en desahucios. El objetivo de esta aplicación es encontrar una manera de para poder relacionarse con los Servicios Sociales de manera electrónica. Esto incluye la notificación electrónica.

12º Información entre aplicativos en subastas judiciales electrónicas. Citando el estudio, “Este aplicativo permite la comunicación automática entre la aplicación de subastas, el BOE y la aplicación de subastas de la aplicación de la Cuenta de Depósitos y Consignaciones Judiciales”.

Hay que resaltar, que el 2 de septiembre de 2023, se creó la Agencia Española de Supervisión de Inteligencia Artificial (AESIA) con sede en La Coruña. Dicha agencia, se regula en el “Real Decreto 729/2023, de 22 de agosto, por el que se aprueba el Estatuto de la Agencia Española de Supervisión de Inteligencia Artificial”.

A destacar, que, según el Ministerio de Política Territorial y Memoria Democrática, España se convierte en “el primer país de la Unión Europea con una agencia estatal de supervisión de la Inteligencia Artificial (IA), anteponiéndose a la entrada en vigor del futuro Reglamento europeo de IA, que establece la necesidad de que los Estados miembros cuenten con una autoridad supervisora en esta materia”.

En cuanto a su objeto y fines, hay que destacar el artículo 4 que “Corresponde a la Agencia llevar a cabo tareas de supervisión, el asesoramiento, la concienciación y la formación dirigidas a entidades de derecho público y privado para la adecuada implementación de toda la normativa nacional y europea en torno al adecuado uso y desarrollo de los sistemas de inteligencia artificial, más concretamente, de los algoritmos. Además, la Agencia tendrá la función de inspección, comprobación, sanción y demás que le atribuya la normativa europea que le resulte de aplicación y, en especial, en materia de inteligencia artificial”.

A esto hay que añadir, que tal y resume Newtral, basándose a su vez en el documento “Estrategia de Inteligencia Artificial 2024”, proporcionado por el Ministerio para la Transformación Digital y de la Función Pública, que adjunto por si alguien quiere profundizar ( https://portal.mineco.gob.es/es-es/digitalizacionIA/Documents/Estrategia_IA_2024.pdf ), “El Gobierno invertirá 10,2 millones de euros en ALIA, una familia de modelos fundacionales en inteligencia artificial (IA) entrenada con datos en español y en las lenguas cooficiales (castellano, catalán, gallego, valenciano y vasco)”.

A continuación, se indica que “A diferencia de GPT, el modelo fundacional del que se nutre la aplicación ChatGPT, ALIA tendrá más de un 20% de entrenamiento en castellano y lenguas cooficiales, frente al menos del 5% de los modelos actuales. Se alimenta con todo tipo de documentos oficiales, desde diarios de sesiones del Congreso de los Diputados, el Boletín Oficial del Estado (BOE) o de la Biblioteca Nacional.

Los primeros resultados de ALIA estarán disponibles (ámbito público y privado) después del verano (2024), aunque según confirman a Newtral.es desde el Ministerio para la Transición Digital y Función Pública su desarrollo no concluirá hasta el primer trimestre de 2026”.

Por último, hay que añadir, que según las “Conclusiones de las XXII jornadas de presidentes/as de Audiencias Provinciales”, celebradas en Valencia, en mayo de 2024, en relación a la Inteligencia Artificial, se indica que “Consideramos que el CGPJ (Consejo General del Poder Judicial) debe liderar la implantación de sistemas de inteligencia artificial como mecanismos de auxilio en la decisión judicial, instando al CTEAJE (Comité Técnico Estatal de la Administración Judicial Electrónica) para que realice el análisis previo a su empleo, autorice su validez y desarrolle su control. La implantación de este tipo de medidas no puede sustituir a la decisión judicial ni constituir instrumentos vinculantes previos a esta decisión.

Los Presidentes/as de Audiencia, por sus funciones ordinarias y conocimiento de los problemas de los Jueces de cada provincia, deben ser colaboradores necesarios en los trabajos que desde el CTEAJE (Comité Técnico Estatal de la Administración Judicial Electrónica) se están realizando en materia de inteligencia artificial.

Interesamos del CENDOJ que incluya en sus bases de datos los acuerdos más relevantes de las Salas de Gobierno con especial atención a la resolución de recursos de alzada en materia sancionadora”.

2.7 El uso de la IA en el sistema judicial de Iberoamérica (Brasil, Argentina, Colombia y México)

Iberoamérica es otra fuente importante de novedades en relación con la aplicación de la Inteligencia Artificial en el ámbito de la Justicia. En este apartado, se van a analizar los casos de Brasil, Argentina, Colombia y México.

En primer lugar, respecto a Brasil, hay que destacar una noticia del marzo de 2020, del periódico brasileño Folha de S. Paulo, donde se menciona que “En el STJ (Tribunal Superior de Justicia), el sistema de IA recibió el nombre de Sócrates y fue «entrenado» utilizando datos de 300.000 decisiones judiciales, según el asesor del tribunal.

Actualmente, la IA «lee» los nuevos procesos y agrupa aquellos que versan sobre temas similares, para que puedan ser juzgados en bloques. El software también se utiliza en la detección para prohibir la entrada de algunos tipos de causas que no están relacionadas con los deberes del juzgado”.

A continuación, voy a citar el estudio “Sistemas de IA en la experiencia del Supremo Tribunal Federal Brasileño y la Corte Constitucional Colombiana: análisis Prospectivo” elaborados por Felipe Calderón-Valencia, Juan-José Pérez y Fausto Santos de Morais (dos abogados colombianos y un abogado brasileño), publicado en marzo de 2021, y disponible gracias a la Universidad de Brasilia, del cual adjunto el enlace (file:///C:/Users/Ill%C3%A1n/Downloads/008+RDET_v13_n1_143to169.pdf ).

El estudio comienza diciendo que “El objetivo del presente texto es analizar la experiencia de la IA en el Supremo Tribunal Federal de Brasil (en adelante, STF), de la Corte Constitucional de Colombia (en adelante, CCC) y del Ministerio Público Fiscal en Argentina en el contexto de la 4RI (4a Revolución Industrial) y la ED (Era Digital)”.

El estudio comienza analizando el caso de Brasil. Según se describe que el Supremo Tribunal Federal de Brasil (equivalente al Tribunal Supremo español) tiene un problema, que, por cierto, también sucede en España, una sobrecarga de trabajo que provoca una congestión y demora en los trámites procesales. Se describe que “Tan solo en el año 2019, el STF (Supremo Tribunal Federal de Brasil) recibió cercade 72.000 recursos de casación” y que “el tiempo promedio para resolver un proceso en Brasil es de cuatro años y diez meses, generándose atraso y demora en la solución de litigios”.

Para solucionar este problema, el Poder Judicial brasileño, mediante un convenio entre el Supremo Tribunal Federal de Brasil y la Universidad de Brasilia, desarrollaron en 2018 el Sistema de IA “VICTOR” (nombrado así, en honor del fallecido ministro Victor Nunes Leal).

Se describe que, “Antes de Víctor, todos los escritos allegados pasaban por la Secretaría del STF STF (Supremo Tribunal Federal de Brasil) quien, con base en los documentos, debía clasificarlos por un tema de Repercusión General. Esta labor requería entre 30 y 40 minutos por escrito, con un margen de precisión de aproximadamente el 75%, debiéndose realizar nuevamente el 25% del trabajo. En julio de 2019 ya se habían estudiado 14.000 de 200.000 expedientes con Víctor, quien realizó la misma tarea de la Secretaría con una precisión del 91% sin tomarse más de cinco segundos por expediente. Estos resultados son bastante alentadores y positivos, aunque existen quienes critican el volumen de expedientes restantes y el hecho de que Víctor no escrutó todos los 1068 temas de Repercusión General. En razón del volumen de expedientes, el STF (Supremo Tribunal Federal de Brasil) seleccionaba los temas relevantes involucrados.

¿Cómo funciona Víctor? Primero, este SIA (Sistemas de IA) identifica los escritos de los recursos y los agrupa en razón de su identidad temática. Posteriormente, el Sistema asocia los recursos con los temas de Repercusión General definidos por el STF (Supremo Tribunal Federal de Brasil). Estos dos actos -identificación y agrupación- son actos de conocimiento que corresponden a valoraciones que normalmente hace el juez en el trámite procesal. A la luz de la agrupación, los ministros del STF (Supremo Tribunal Federal de Brasil) definen si el tema es de Repercusión General o no y deliberan cómo debe resolverse. Para ello, el STF (Supremo Tribunal Federal de Brasil) define un enunciado, una proposição sumular”.

René Urueña, profesor de Derecho en la Universidad de los Andes (Colombia), indica, en una fuente distinta, que “Según su desarrollador, VICTOR tendría una precisión del 90.34% clasificando los recursos”.

Volviendo al estudio de antes, se indica, que, si bien este sistema puede reducir la sobrecarga de trabajo, se alerta del Riesgo de la Hipernormativización Artificial. Citando el estudio “El fenómeno de la hipernormatização artificial (HNA) tiene cabida cuando los elementos de hecho o de derecho considerados en una decisión judicial no se formalizan adecuadamente en una premisa para su uso por un SIA (Sistemas de IA). Por consiguiente, el SIA (Sistemas de IA) opera con una premisa artificial que se “híper-estabiliza” progresivamente – en ocasiones antes de que se ejecute el programa en circunstancias reales (CALDERON-VALENCIA; SANTOS DE MORAIS, 2020)-.

Víctor permite producir parámetros rígidos para la valoración judicial. Estos parámetros son indirectamente producidos por el STF (Supremo Tribunal Federal de Brasil) puesto que son los ministros del STF (Supremo Tribunal Federal de Brasil) quienes calibran a Víctor. Estos parámetros rígidos revisten características de actos normativos -muchas veces sin serlo-, lo que da lugar a la HNA (Hipernormativización Artificial). La definición de los temas presupone la premisa operacional que conducirá el funcionamiento de Víctor. Así, aunque la eficiencia del SIA (Sistemas de IA) y su apoyo a la mano de obra humana es incuestionable, el problema de la HNA no puede descartarse. Este problema puede resultar porque se consignan en el software de manera artificial elementos de hecho o de derecho”.

Se añade más adelante que “El primer problema en la modelación de Víctor como SIA (Sistemas de IA) es, tal vez, la HNA (Hipernormativización Artificial). En parte, éste es resultado de la falta de asimilación de los jueces y abogados de la importancia que reviste la actividad judicial y la jurisprudencia en el orden normativo brasileño, pasando por alto que las reglas pretorianas no son en sí mismas un enunciado textual (Streck, 2013), sino más bien, un enunciado contextual”. Es por eso que se indica que debe de haber mecanismos que permitan la humanización de la Hipernormativización Artificial.

A continuación, se habla del Sistema de IA de Colombia, llamado “PRETORIA”. Se explica que “Este SIA (Sistemas de IA) fue desarrollado por el Laboratorio de Innovación e IA de la Universidad de Buenos Aires (IALAB14) en convenio con la Universidad del Rosario y otras instituciones colombianas”.

Se prosigue diciendo que “Pretoria tiene como objetivo principal hacer más eficiente la justicia por parte de la CCC (Corte Constitucional Colombiana). Aunque aún se encuentra en la fase piloto (RIVADENEIRA, 2019), Pretoria es capaz de analizar 2016 decisiones en menos de dos minutos, cargar de forma automatizada a Blockchain treinta y dos providencias y crear alrededor de catorce documentos en dieciséis minutos. Aunado a esto, es capaz de reconocer y responder de forma masiva a las cuestiones más demandadas en materia de acciones de tutela. La labor de Pretoria aportaría significativamente a la ya precaria administración de justicia colombiana, la cual con el Covid-19 dejó ver su distancia de la tecnología en un mundo interconectado. Por ello, para entender a (2.2.) Pretoria y su experiencia en la justicia colombiana, primero debemos analizar el (2.1.) caso de Prometea en Argentina”.

Respecto al Sistema de IA de Argentina, llamado “PROMETEA”, voy a citar el artículo titulado “¿Máquinas de Justicia?: Inteligencia Artificial y Sistema Judicial en América Latina”, publicado en febrero de 2021 por René Urueña, profesor de Derecho en la Universidad de los Andes (Colombia), el cual ya cité anteriormente, indica que “Más avanzado en la línea de la decisión autónoma es Prometea, desarrollado por un equipo en el Ministerio Público Fiscal de la Ciudad Autónoma de Buenos Aires. El piloto, lanzado en 2017, se centró en la decisión de amparos habitacionales que llegan al Tribunal; esto es, el recurso mediante el cual se pide al gobierno una vivienda digna, y posteriormente se ha implementado a casos de bonificaciones en empleo público, ejecución de multas no pagadas, negación de licencias de taxi por antecedentes penales, y denuncias por violencia de género, entre otros. En estos casos, la contribución de Prometea es analizar el texto del recurso y las actuaciones previas, verificar la presencia de ciertas palabras clave que han sido preconfiguradas en el sistema, y predecir la respuesta apropiada a la solicitud: por ejemplo, el dictamen que debe rendir la Fiscalía en un amparo habitacional. Posteriormente, el sistema organiza un borrador de la decisión o dictamen, y le hace algunas preguntas al operario judicial para ajustar el documento, que es finalmente revisado por un humano. Según su desarrollador, Prometea tendría una precisión de 96% en su predicción”.

Volviendo al estudio anteriormente citado, se expone que “Otro ejemplo concreto es la participación de Prometea en la solución de juicios ejecutivos en materia de responsabilidad fiscal. Como se trata de procedimientos de baja complejidad, el margen de error de la máquina es mínima, contribuyendo a su descongestión y simplificación. La proyección de una sentencia ejecutiva podría reducirse de media hora a tan solo seis minutos (CORVALÁN, 2019)”.

Más adelante, el estudio vuele a centrarse en el Sistema de IA “PRETORIA” de Colombia. Se argumenta que “Pretoria es producto del éxito de Prometea en Argentina. Al principio, el objetivo era que la Prometea colombiana asistiera a los Magistrados de la CCC (Corte Constitucional Colombiana) en el trámite de la preselección para la revisión eventual de fallos de tutela a través de los métodos de síntesis y predicción. No obstante, se prefirió crear un SIA propio y adecuado al caso colombiano. Para la creación, diseño y programación de Pretoria, la CCC contó con recursos privados de la Cámara de Comercio de Bogotá y de CORFERIAS”.

A todo esto, hay que añadir que “Pretoria se parece a Víctor en el sentido de que son los mismos Magistrados quienes calibran el SIA (Sistemas de IA), esto es, ellos fijan los criterios para la preselección. Por otro lado, se parece a Prometea en que su sistema inteligente tiene como fin la síntesis y la predicción de soluciones a posibles casos, emitiendo informes detallados con premisas lógicas y estadísticas producto de la lectura de fallos escaneados. Aunado a esto, Pretoria utiliza el sistema de nodos de Blockchain para aportar certeza, seguridad y transparencia en la información, permitiendo que la misma sea almacenada en bloques (CORRALES; FENWICK; HAAPIO, 2019). Además, se basa en el método del Machine Learning que le permite mejorar y perfeccionar su conocimiento artificial.

En suma, Pretoria resulta una herramienta muy completa que implementa mejoras de los anteriores SIA (Sistemas de IA). Esto se ve reflejado en la tarea de preselección de tutelas para su eventual revisión, organizándolas por orden de urgencia de acuerdo con los parámetros establecidos por los Magistrados que conforman las Salas de Revisión y la propia sistematización avanzada de la jurisprudencia que hace la máquina. Adicionalmente, Pretoria se caracteriza porque se sirve de una herramienta conversacional activada por comando de voz o chat que humaniza su labor”.

Otro Sistema de IA de Colombia que hay que destacar es el Sistema “PRISMA” (no confundir con el Sistema de la Junta de Andalucía del mismo nombre). Para analizar esta IA, me voy a basar es el trabajo (Trabajo de Grado-Pregrado) “Inteligencia artificial y reincidencia: Control inteligente del delito. ¿Efectividad de los cupos carcelarios? Aproximación al Sistema Prisma de la Fiscalía General de la Nación”, de Natalia Moreno Blanco, publicado en la Universidad de los Andes (Colombia), en noviembre de 2019.

En el resumen del trabajo se indica que “El Sistema Prisma es un mecanismo de inteligencia artificial que busca servir como herramienta para argumentar y justificar ante el juez de control garantías la necesidad de imposición de una medida de aseguramiento consistente en detención preventiva en centro carcelario”.

En cuanto a cómo funciona el sistema PRISMA, se indica que “el funcionamiento de PRISMA tiene como objetivo predecir la probabilidad de reincidencia de un individuo, en esta medida se considera pertinente dilucidar lo que PRISMA entiende como reincidente ya que este calificativo no es igual al que se adopta en el Sistema Penal acusatorio colombiano.

En efecto, PRISMA determina que el riesgo de reincidencia no tiene estrictamente el número de condenas que tenga la persona, si no que la reincidencia de un individuo se basa en el número de capturas, número de imputaciones, acusaciones, y condenas. No obstante, aunque no es claro el valor de cada variable, el académico Daniel Mejía describe que al ser PRISMA un sistema de machine learning no tiene en cuenta los números de manera aislada, sino que permite establecer correlaciones entre los mismos y solo mediante una cifra importante de estas variables empieza a arrojar resultados de alta probabilidad de reincidencia. Por ejemplo, es sólo después de la décima captura que el sistema aprende su importancia y llega a conclusiones aproximadas de que la persona entró en una carrera criminal y por tanto su probabilidad de reincidir es mucho mayor”.

El listado de debilidades mencionados en el trabajo es el siguiente:

“1. No tiene en cuenta el rol de la Defensoría del Pueblo.

2. Asume una relación directa entre el uso del sistema y la disminución del otorgamiento de medidas de seguridad a individuos poco peligrosos para la sociedad.

3. Se basa en un concepto general de antecedentes criminales.

4. El Sistema puede crear una discriminación indirecta.

5. La herramienta puede usarse selectivamente por parte del Fiscal.

6. El Sistema no contempla mecanismo de rendición de cuentas”.

Dentro de estas debilidades, hay que destacar la reflexión de la autora en cuanto al punto dos de la debilidad “Asume una relación directa entre el uso del sistema y la disminución del otorgamiento de medidas de seguridad a individuos poco peligrosos para la sociedad”, la autora argumenta que “el criterio del juez va mucho más allá de la simple probabilidad de reincidir, en la medida que toma en cuenta para el otorgamiento de la medida, factores individuales y sociales del imputado. Por tanto, PRISMA al hacer predicciones de disminuir en el 36% el otorgamiento de medidas de aseguramiento no tiene en cuenta la discrecionalidad del juez como variable o como porcentaje de error”.

El listado de fortalezas mencionados en el trabajo es el siguiente:

“1. Es coherente con y permite cumplir los objetivos, del Plan de transformación carcelario, parte de la política criminal estatal.